Werk je met AI, dan valt één ding snel op: iedereen heeft het over ChatGPT, Gemini of Grok. Maar deze bekende tools zijn lang niet altijd de beste keuze voor jouw proces. Kijk mee hoe wij per vraagstuk de beste keuze maken met gebruik van Promptfoo.

Modellen versus tools

Eerst even terug. We kennen ChatGPT natuurlijk allemaal. Het is een product (of tool) van het bedrijf OpenAI, net zoals Gemini bijvoorbeeld een product van Google is. Onder deze producten draaien verschillende Large Language Modellen (LLM’s), denk aan GPT-4.1, Claude, Gemini 2.0, Llama-varianten of lokale modellen via Ollama.

Maar die modellen verschillen flink in prijs en kwaliteit. Sommige modellen schrijven fantastische code, maar gaan de mist in met bijvoorbeeld Nederlandse spreekwoorden. Andere modellen zijn supersnel en goedkoop, maar halen lagere kwaliteit bij complexe taken. En weer andere modellen zijn juist extreem goed in redeneren, maar duur in gebruik.

Toch zien we vaak dat organisaties ‘één AI’ kiezen en die overal voor gebruiken. Handig voor op de korte termijn, maar ook risicovol: je betaalt waarschijnlijk te veel en krijgt soms mindere kwaliteit dan nodig.

Je móet AI-modellen testen en benchmarken

LLM’s zijn geen statische API’s. Die modellen worden namelijk regelmatig bijgewerkt, providers wisselen met hun prijzen, en de kwaliteit schommelt door drukte of nieuwe versies. Zeker als je modellen gebruikt die je zelf niet host, heb je daar weinig controle over. Zonder testing en benchmarking loop je daarom risico op:

- Wisselende kwaliteit: gisteren werkte je flow prima, maar vandaag niet meer;

- Onnodige kosten: omdat je een dure ‘flagship AI’ gebruikt, terwijl een kleiner model hetzelfde doet;

- Vendor lock-in: je organisatie raakt afhankelijk van één leverancier;

- Lastige discussies: ‘het voelt trager’ is lastig uit te leggen, meetbare cijfers niet.

Promptfoo: open source framework

Wij testen alle LLM-modellen op structurele wijze. Hierbij maken wij gebruik van bijvoorbeeld Promptfoo.

Promptfoo is een open source framework om LLM-toepassingen te testen en te benchmarken. Je beschrijft in YAML (YAML Ain’t Markup Language, mensvriendelijk dataformaat) of in code:

- Welke taken je wil testen;

- Welke modellen/providers je wil vergelijken (OpenAI, Anthropic, Google, Azure, lokale modellen);

- Welke checks moeten slagen (bijvoorbeeld: bevat het antwoord een spreekwoord, is de JSON valide, is de toon vriendelijk).

Op basis van deze input draait Promptfoo automatisch al je testcases, toont de resultaten in een matrix én kan zo onderdeel worden van je CI/CD-pipeline.

Kort gezegd: Promptfoo brengt ouderwets testen naar moderne AI-toepassingen.

Kleine test uit onze praktijk

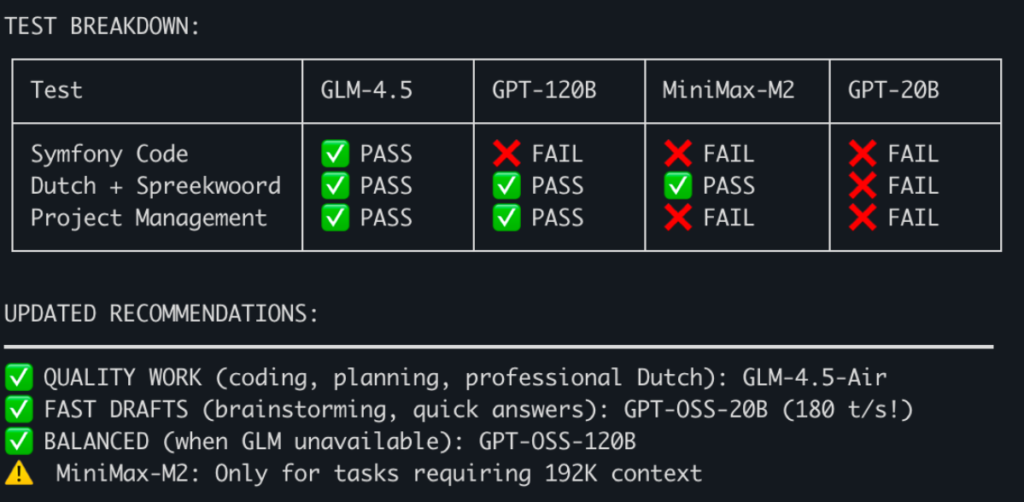

In de screenshots bij dit artikel zie je één van onze eigen runs met Promptfoo. We vergeleken vier modellen op drie realistische taken:

- Symfony controller schrijven met validatie;

- E-mail in het Nederlands naar een IT-manager, mét echt Nederlands spreekwoord;

- Projectplan User Registration voor een solo-developer (20 uur/week), inclusief fases en risico’s.

Screenshot 1:

Promptfoo draait de testset in één klap. Per model zie je:

- Welke cases PASS of FAIL zijn;

- Hoeveel tokens (en dus kosten) zijn gebruikt;

- Het totale slagingspercentage.

In ons voorbeeld kwam één model duidelijk als beste uit de bus voor deze mix van taken. In een tweede screenshot zie je ook de samenvatting en dit laat precies zien wat we bedoelen: er is niet één beste AI. Het hangt af van de taak.

Screenshot 2:

- QUALITY WORK (coding, planning, professioneel Nederlands): Model A;

- FAST DRAFTS (brainstormen, snelle antwoorden): Model B;

- BALANCED (als model A niet beschikbaar is): Model C;

- Model D: alleen nuttig voor niche-cases, bijvoorbeeld extreem grote context.

Hoe En Masse Promptfoo inzet in organisaties

Bij het implementeren van een AI-oplossing, doorlopen we grofweg de volgende stappen:

- Processen in kaart brengen: samen met het team bepalen we welke stappen écht belangrijk zijn. Code genereren, e-mails beantwoorden, samenvattingen, rapportages.

- Echte use-cases omzetten in tests: geen ‘lorem ipsum’-prompts maar realistische voorbeelden: echte klantvragen, echte tickets, echte interne teksten. Voor iedere testcase beschrijven we wat een goed antwoord is.

- Promptfoo configureren: in YAML leggen we vast welke modellen we willen testen, welke prompts of agents we gebruiken en welke criteria bepalen of een antwoord goed is (bijvoorbeeld: moet een spreekwoord bevatten, mag geen privacygevoelige data lekken, moet geldbedragen in euro vermelden).

- Benchmark draaien en analyseren: Promptfoo draait alles door en toont een overzichtelijke matrix met scores, latency en kosten per model. Zo kunnen we onderbouwd kiezen. Soms wint een ‘klein’ model met gemak van een dure topper.

- Continu monitoren: dezelfde tests draaien we periodiek of bij elke deployment. Als een provider onder water een model wijzigt en de kwaliteit daalt, zien we dat direct in de resultaten. Zo voorkom je dat klanten de eerste zijn die het merken.

Wat levert het gebruik van Promptfoo jou op?

Dat wij fan zijn van Promptfoo moge duidelijk zijn. Nu wil jij natuurlijk weten wat het voor jou als organisatie oplevert. Komt ‘ie:

- Betere kwaliteit: je gebruikt het LLM-model dat aantoonbaar het beste presteert op jóuw taken;

- Lagere kosten: geen overkill-modellen voor simpele taken;

- Minder risico: regressies en rare model-updates zie je in je tests en niet pas in productie (of na een belletje van de klant);

- Transparantie richting management: in plaats van ‘het voelt beter’ kun je het laten zien met duidelijke cijfers: hogere score, lagere maandelijkse kosten.

Ook verder kijken dan ‘één AI’?

Werk je nu vooral met ChatGPT en ben je benieuwd welke modellen het beste passen bij jouw processen? Wij helpen je graag! Samen brengen we jouw belangrijkste AI-taken in kaart, zetten we een pragmatische testset op met bijvoorbeeld Promptfoo en kiezen we een modelstrategie die past bij kwaliteit, kosten en risico. Klinkt goed toch?

Bel of mail ons, dan laten we je live zien hoe zo’n benchmark werkt; inclusief kleurrijke PASS/FAIL-matrix. Want wij zeggen niet voor niets heel graag “niet mouwen maar (meteen) bouwen”.